In einem Backrezept für eine mehrstöckige Torte sind von dem Teig bis zur Creme die Zutaten und die einzelnen Herstellschritte beschrieben. So ähnlich, nur viel komplexer funktionieren Algorithmen, wie sie in den Systemen der künstlichen Intelligenz eingesetzt werden. Nach einer festen Abfolge von Schritten können sie uns Lebenspartner vorschlagen, die vielleicht zu uns passen, oder Unternehmen darin unterstützen, die richtigen Bewerber zu finden. Dafür greift die Computersoftware auf eine Menge von Informationen zu – bei Bewerbern etwa auf das Geschlecht, die Abiturnote, die Religion oder den Wohnort der Menschen – und setzt diese in eine Beziehung zueinander.

Bisherige Erfahrungen mit solchen virtuellen Entscheidungen zeigen ein grundlegendes Manko: Es fehle ihnen mitunter an Fairness, sagt der Philosoph und Mathematiker Bernhard Schölkopf vom Max-Planck-Institut für Intelligente Systeme in Tübingen. Im Jahr 2018 wurde bekannt, dass ein beim Internethändler Amazon entwickeltes Bewerbungsprogramm bei der Vorauswahl Frauen benachteiligte, indem es sie häufiger ausfilterte. Schölkopf und seine Kollegen haben nun eine Methode entwickelt, die den Systemen helfen soll, fairer vorzugehen. Das Ziel: Die Software soll lernen, für jede einzelne Entscheidung den jeweils richtigen kausalen Zusammenhang zu finden.

Die unfaire Suche nach Mustern

Warum sind Entscheidungen lernender Systeme nicht immer fair? Algorithmen wissen nicht, welchen Einfluss Daten wie etwa Geschlecht, Herkunft oder Religion, auf die sie bei ihrer Entscheidung zugreifen, in der Wirklichkeit haben. Stattdessen suchen sie, wie Schölkopf erklärt, in den großen Datenmengen nach Mustern, etwa nach Wenn-dann-Beziehungen.

Ein Beispiel: Wenn Algorithmen nach dem Grundsatz „gleiche Chancen für Mann und Frau“ die gleiche Anzahl von Männern und Frauen auswählen, muss das nicht gerecht sein, weil die Qualifikation der Kandidaten zu wenig berücksichtigt wird. Denn es könnten ausgerechnet die qualifiziertesten Männer und die unqualifiziertesten Frauen sein. „Solche statistischen Paritätskriterien sind in der Praxis nicht hinreichend, um Fairness zu garantieren“, sagt der Physiker Niki Kilbertus, Wissenschaftler im Team von Schölkopf, der in seiner noch nicht fertiggestellten Promotion an dem Thema forscht.

Auch die Qualität und die Aktualität der Daten spielen eine wichtige Rolle: Computer arbeiteten häufig mit historischen Daten – wenn diese immer wieder verwendet werden, passieren auch immer wieder dieselben Diskriminierungen. „Die Gefahr liegt darin, dass die historischen Daten nicht die ethischen und moralischen Kriterien widerspiegeln, die wir für angemessen halten“, so Kilbertus.

„Die Maschinen haben kein Verständnis von Fairness“

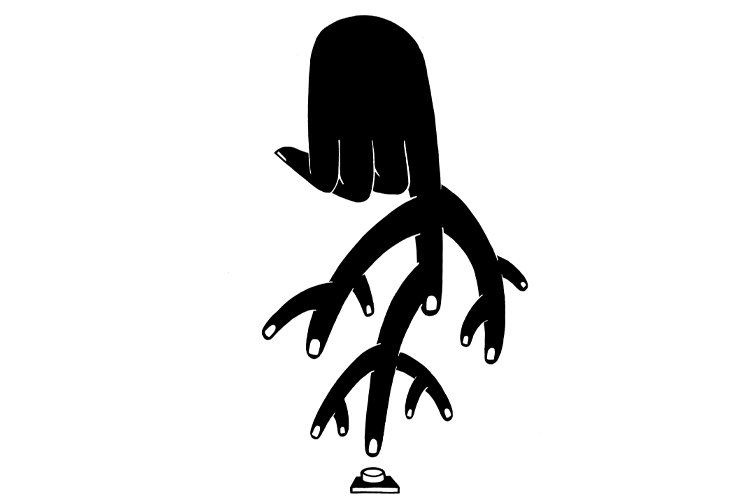

Um zu veranschaulichen, wie die Entscheidung eines Algorithmus zustande kommt, fertigten die Wissenschaftler eine Grafik an, in der – wie bei einem Programm zur Bewertung von Bewerbungen – Kriterien wie Geschlecht, Herkunft oder Abiturnote in Beziehung zueinander stehen. Es wird auch abgebildet, welchen Einfluss sie auf das Bewerbungsverfahren haben können.

In dieser Grafik sind die wichtigsten Knotenpunkte und kausalen Zusammenhänge für den Computer dargestellt. Pfeile verdeutlichen, in welcher Beziehung die Variablen, also etwa Geschlecht, Herkunft oder Abiturnote, zueinander stehen. Für jeden beliebigen Fall kann dann theoretisch eine Grafik mit kausaler Struktur gebildet werden, um so unfaire Verbindungen aufzudecken. Wenn das System aufgrund dieser Vorgaben die richtigen kausalen Zusammenhänge und Verkettungen ermittelt, kann es potenziell geeignete Bewerber vorschlagen und „fair“ sein.

Das allerdings nimmt Menschen nicht die letztendliche Entscheidung ab: Was als fair gilt, darüber muss man sich weiterhin Gedanken machen: „Die Maschinen selbst haben kein Verständnis von Fairness. Die Entscheidung darüber, was fair ist, liegt nach wie vor beim Menschen“, sagt Niki Kilbertus. Wenn darüber Konsens besteht, sollen mithilfe der Grafik „unfaire Pfade“ in dem Netzwerk „herausgerechnet“ werden, so dass die Computer keine unangemessenen Empfehlungen mehr geben können.

Fairness ist kein mathematisches Kriterium

Kilbertus: „Wir liefern eine Methode, wie man diese kausale Struktur berücksichtigen kann, wir wollen aber nicht entscheiden, was fair oder unfair ist.“ Schließlich sei dies kein formales mathematisches Kriterium: „Fairness ist kein Problem, das wir mathematisch eindeutig definieren und technisch lösen können.“ Auch innerhalb des Forscherteams gebe es dazu ganz unterschiedliche Ansichten. Der Anspruch der Forscher ist dennoch hoch: „Wir liefern eine Sprache, um über Fairness in einem formalen Rahmen sprechen zu können“, erklärt Kilbertus.

Eine Sprache, die auch das System versteht. Mit der von Schölkopf, Kilbertus und Kollegen entwickelten Methode gilt der mathematische Beweis als erbracht, dass es grundsätzlich möglich ist, die „unfairen Verbindungen“ aus den Computerprogrammen herauszurechnen. Allerdings gebe es bislang keine technische Lösung, mit der sich Fairness „vom Fleck weg“ in allen Anwendungen umsetzen lasse.

Weltweit haben sich in der Forschung mittlerweile Initiativen gebildet, die sich für Fairness und Transparenz in der künstlichen Intelligenz einsetzen. Sie wollen dafür sorgen, dass Computersysteme nicht bestimmte Gruppen bevorzugen und andere diskriminieren. Sie fordern, dass sich Unternehmen für das Handeln ihrer Maschinen verantwortlich zeigen.

Niki Kilbertus u.a.: Avoiding discrimination through causal reasoning. Advances in Neural Information Processing Systems, 2017